인공지능(AI) 기술의 혁신을 선도하며 세상을 놀라게 했던 오픈AI(OpenAI)의 화려한 명성 뒤에 짙은 그림자가 드리우고 있습니다. 한때 AI 시대를 여는 개척자로 칭송받던 이 기업에서 최근 몇 달 사이 핵심 인재들이 연이어 회사를 떠나는 심상치 않은 일이 벌어지고 있습니다. 특히 최고커뮤니케이션책임자(CCO) 해나 웡(Hannah Wong)의 퇴사는 이러한 흐름에 정점을 찍으며, 오픈AI가 맞닥뜨린 내부적 위기가 수면 위로 드러나는 계기가 되었습니다.

단순한 인재 이동으로 치부하기에는 그 무게가 너무나도 큽니다. 이번 사태는 단순한 개인의 선택을 넘어, 기술의 발전 속도와 안전성 사이에서 벌어지는 거대한 이념적 충돌의 결과물일 수 있습니다. 과연 오픈AI 제국의 심장부에서는 무슨 일이 벌어지고 있는 것이며, 이는 앞으로 우리가 사용하게 될 AI 기술과 우리 사회에 어떤 파장을 몰고 올까요? 이제 그 이면에 숨겨진 진실을 깊이 파헤쳐 보고자 합니다.

해나 웡, 단순한 CCO 그 이상의 의미

해나 웡은 단순한 임원이 아니었습니다. 그녀는 2021년 합류 이후, 챗GPT(ChatGPT)라는 혁신적인 제품을 세상에 알리고 대중과 소통하는 방식 전체를 설계한 인물입니다. 특히 지난해 샘 올트먼 CEO가 갑작스럽게 해임되었을 때, 그녀는 혼란의 중심에서 대외 커뮤니케이션을 총괄하며 회사가 붕괴 직전의 위기에서 벗어나는 데 결정적인 역할을 했습니다. 그녀의 존재는 오픈AI의 ‘입’이자 ‘얼굴’이었으며, 기술적 성과만큼이나 중요한 회사의 신뢰와 이미지를 구축한 장본인이었습니다.

그런 그녀가 회사를 떠난다는 것은 오픈AI가 외부 세계와 소통하는 방식에 근본적인 변화가 생길 것임을 암시합니다. 샘 올트먼 CEO는 그녀의 노고에 감사를 표하면서도, 이제는 회사의 소통 방식이 달라져야 할 시점이라는 미묘한 여운을 남겼습니다. 이는 과거의 위기를 수습하고 안정화를 이끌었던 방식에서 벗어나, 더욱 공격적이고 상업적인 방향으로 나아가려는 회사의 의지를 보여주는 것일 수 있습니다. 안정의 상징이었던 인물의 퇴사는 역설적으로 새로운 불안정의 시작을 알리는 신호탄이 된 셈입니다.

멈추지 않는 인재 유출: 단순한 이직인가, 위험 신호인가?

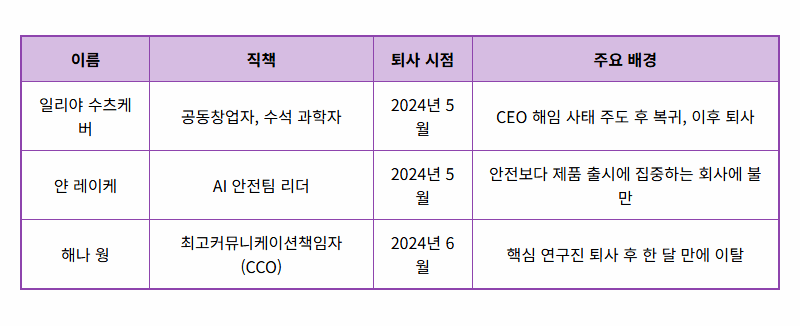

해나 웡의 퇴사가 더욱 심각하게 받아들여지는 이유는 이것이 단독적인 사건이 아니기 때문입니다. 불과 한 달 전, 오픈AI의 공동 창업자이자 인공지능의 미래 방향을 제시하던 수석 과학자 일리야 수츠케버가 회사를 떠났습니다. 그와 함께 AI의 잠재적 위험을 연구하고 통제하는 ‘슈퍼얼라인먼트(Superalignment)’ 팀을 이끌던 얀 레이케 역시 “안전 문화와 프로세스가 뒷전으로 밀렸다”는 비판을 남기며 사임했습니다.

이들의 연쇄적인 이탈은 단순한 이직 현상이 아니라, 오픈AI 내부의 심각한 균열을 보여주는 명백한 증거입니다. 회사의 두뇌(수츠케버), 양심(레이케), 그리고 입(웡) 역할을 하던 핵심 인물들이 모두 등을 돌린 것입니다. 이는 오픈AI가 인류에게 안전한 AI를 개발하겠다는 창립 이념과, 시장에서의 경쟁 우위를 차지하려는 상업적 야망 사이에서 심각한 정체성 혼란을 겪고 있음을 시사합니다. 특히 AI 안전팀의 사실상 와해는 기술의 고삐를 쥘 사람이 사라지고 있다는 위험한 신호로 해석될 수밖에 없습니다.

‘안전’과 ‘속도’의 갈림길에서 길을 잃다

결국 이번 사태의 본질은 ‘안전’과 ‘속도’ 사이의 전쟁입니다. 오픈AI 내부에는 인류의 미래를 위해 신중하고 안전하게 초지능을 개발해야 한다는 ‘안전 우선’ 그룹과, 구글, 앤트로픽 등 경쟁사들을 따돌리고 시장을 선점하기 위해 더 빠르고 강력한 모델을 출시해야 한다는 ‘속도 우선’ 그룹 간의 보이지 않는 싸움이 계속되어 왔습니다. 샘 올트먼의 해임과 복귀 과정에서 결국 ‘속도 우선’ 그룹이 승기를 잡았고, 그 결과 ‘안전 우선’ 그룹의 핵심 인물들이 설 자리를 잃고 회사를 떠나게 된 것입니다.

이러한 방향 전환은 단기적으로는 더 새롭고 놀라운 기능들을 우리에게 선보일 수 있습니다. 하지만 장기적으로는 통제 불가능한 AI의 등장을 앞당기는 위험한 도박이 될 수 있습니다. 브레이크 없이 질주하는 자동차가 결국 큰 사고로 이어지듯, 안전에 대한 충분한 고려 없이 속도에만 매몰된 기술 개발은 예측할 수 없는 사회적 재앙을 초래할 수 있습니다. 오픈AI의 선택은 AI 산업 전체에 ‘속도’가 ‘안전’을 압도하는 위험한 선례를 남길 수 있다는 점에서 깊은 우려를 낳고 있습니다.

챗GPT 사용자와 AI 생태계에 미칠 영향

그렇다면 이러한 내부 혼란이 우리 같은 일반 사용자들에게는 어떤 영향을 미칠까요? 단기적으로는 챗GPT 서비스 자체에 큰 변화를 체감하지 못할 수 있습니다. 하지만 핵심 개발자와 연구진의 공백은 중장기적으로 기술 혁신의 둔화, 잦은 오류 발생, 그리고 예측하지 못한 윤리적 문제 발생 가능성을 높일 것입니다.

더 큰 문제는 AI 기술에 대한 사회적 신뢰의 붕괴입니다. 선두 기업인 오픈AI가 안전을 경시하는 모습을 보인다면, 사람들은 AI 기술 자체에 대한 불안감과 불신을 갖게 될 것입니다. 이는 건전한 AI 생태계의 발전을 저해하고, 섣부른 규제 도입으로 이어져 오히려 기술 혁신의 발목을 잡는 악순환을 낳을 수 있습니다. 소비자로서 우리는 특정 기업의 기술에 맹목적으로 의존하기보다, AI 기술이 투명하고 안전하게 개발되고 있는지 지속적으로 감시하고 목소리를 내야 합니다. 기술의 혜택을 누리는 만큼, 그 기술이 올바른 방향으로 나아가도록 견제하고 요구할 책임 또한 우리에게 있습니다.

기술을 넘어 신뢰를 생각할 때

오픈AI의 핵심 인력 연쇄 이탈 사태는 AI 기술 개발이 단순히 코딩과 알고리즘의 문제가 아님을 명확히 보여줍니다. 그것은 결국 ‘사람’의 문제이며, ‘신뢰’의 문제입니다. 아무리 뛰어난 기술이라도 그것을 만드는 사람들의 철학과 가치관이 흔들린다면, 그 기술은 인류에게 득이 아닌 해가 될 수 있습니다.

이번 위기를 계기로 오픈AI가, 그리고 AI 산업 전체가 ‘무엇을 위해, 어떻게’ 기술을 발전시켜 나갈 것인지에 대한 근본적인 성찰을 하기를 기대합니다. 화려한 기술의 이면에 숨겨진 그림자를 직시하고, 속도 경쟁을 넘어 인류 전체의 미래를 위한 책임감 있는 행보를 보여줄 때 비로소 AI 기술은 우리 사회에 진정으로 기여할 수 있을 것입니다. 앞으로 오픈AI가 이 위기를 어떻게 극복하고 신뢰를 회복해 나갈지, 우리는 그 과정을 냉철하게 지켜봐야 할 것입니다.